Fentanyl, la droga letale in rapidissima diffusione

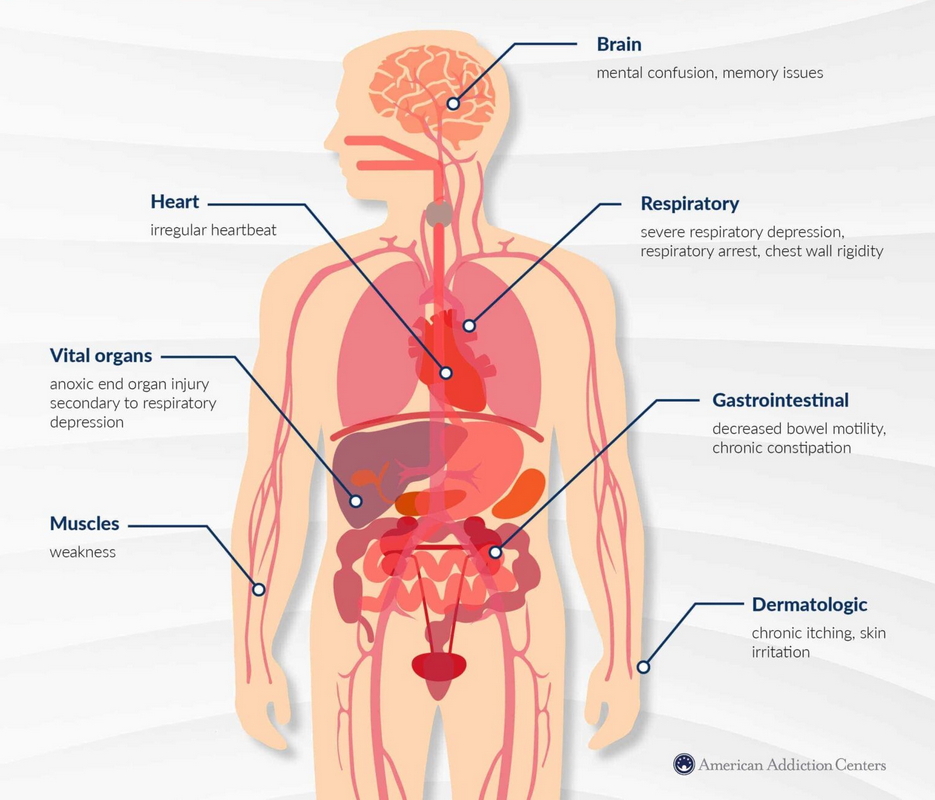

È un oppioide sintetico nato come farmaco antidolorifico e anestetico. Potentissimo, sta facendo migliaia di vittime nel Nord America. Ma è arrivato anche sulle piazze dello spaccio italiane ed europee. L’allarme è grande e giustificato.

Ascoltando la splendida Purple rain, il pensiero corre subito a Prince, il genio di Minneapolis, che venne ucciso il 21 aprile 2016 da un’overdose di fentanyl. Questo è un oppioide sintetico che il cantante statunitense aveva assunto in seguito all’intervento a un’anca. Lo stesso fentanyl sarebbe la causa della morte nel 2018 di Dolores O’Riordan, la cantante dei Cranberries e di Tom Petty (morto nel 2017), un cantautore e chitarrista statunitense che lavorò anche con Bob Dylan. Questi sono alcuni dei casi più famosi di morti legate all’abuso di fentanyl, sostanza che sta uccidendo centinaia di migliaia di persone ogni anno negli Usa e in Canada e che, da qualche tempo, ha fatto il suo ingresso anche in Europa, dove si teme possa verificarsi un’analoga situazione, benché, per il momento, il numero dei decessi sia ancora basso.

La potenza del fentanyl spiega le sempre più frequenti morti per overdose di coloro che se lo procurano per strada o via dark web oppure lo consumano inconsapevolmente, perché, da qualche anno, viene utilizzato come sostanza da taglio per eroina, cocaina, allucinogeni ed ecstasy. In totale, nel 2023 i decessi per overdose negli Usa hanno superato le 112mila unità e per oltre l’80% di loro il responsabile è stato il fentanyl.

Le cause della diffusione

Per capire come questo farmaco sia diventato una delle droghe più diffuse e sia aumentato enormemente il numero di coloro che ne sono diventati dipendenti è necessario risalire ai primi anni Novanta.

All’epoca i medici negli Usa iniziarono a prescrivere il fentanyl come antidolorifico, con una certa disinvoltura legata ad una vera e propria campagna di disinformazione mirata a farne aumentare le prescrizioni, campagna messa in atto da diverse case farmaceutiche. Contro di esse, nel corso degli anni, si sono accumulate oltre duemila azioni legali che hanno portato, tra l’altro, al fallimento della Purdue Pharma. Nella sua campagna promozionale veniva infatti asserito che il fentanyl non crea dipendenza, mentre invece è provato che il suo abuso porta a una gravissima forma di dipendenza e al rischio di overdose.

Un’altra causa della diffusione del fentanyl illegale negli Usa è insita nella mancanza in questo Paese di un sistema di assistenza sanitaria universale, sostituita dal sistema assicurativo. Questo ha portato i meno abbienti a rivolgersi al mercato clandestino dei narcotrafficanti che su queste droghe hanno creato un impero, soprattutto quando il legislatore ha tentato di arginare la situazione rendendo più controllate la prescrizione e la distribuzione del fentanyl.

Protagonisti sono i cartelli messicani che, da anni, immettono negli Usa e in Canada grosse partite di fentanyl. Si sospetta che stiano tentando di orientare tutto il consumo di droghe verso questa sostanza che, come detto, viene utilizzata anche come adulterante di altre droghe. Questa situazione è fonte di enormi guadagni per i cartelli della droga per più di un motivo: il fentanyl crea forte dipendenza, è facile da produrre e costa poco perché, come tutti gli oppioidi sintetici, non necessita di piantagioni (che infatti in Messico stanno diminuendo), non è soggetto all’aggressione dei parassiti o alle variazioni climatiche.

Inoltre, dato che il fentanyl è molto potente, circa 50 volte l’eroina, è molto più facile da trafficare: basta pensare che 100 grammi di fentanyl equivalgono a 5 kg di eroina.

La geopolitica del fentanyl: Cina, Messico, Usa

I narcotrafficanti messicani hanno organizzato nel loro territorio dei laboratori clandestini, nei quali specialisti di chimica assoldati allo scopo sintetizzano questa e altre sostanze a partire dai loro precursori provenienti dall’Asia. Tuttavia, essi acquistano anche grandi quantitativi di fentanyl a basso prezzo direttamente dalla Cina, che da anni ne è il più grande produttore mondiale. E ciò nonostante il governo di Pechino abbia dichiarato l’illegalità della sua produzione e si sia impegnato a perseguire chi lo sintetizza. E ciò su pressione degli Stati Uniti, con cui la Cina ha ratificato un accordo in occasione di un incontro – tenutosi a San Francisco lo scorso novembre – tra il presidente americano Joe Biden e il presidente cinese Xi Jinping.

Per capire la portata di questo giro d’affari, basta considerare quanto afferma un rapporto della Dea (Drug enforcement administration), l’agenzia federale antidroga degli Usa, secondo cui un chilo di fentanyl a elevato grado di purezza acquistato in Cina costa tra i 3.300 e i 5.000 dollari.

Una volta mescolato ad altre sostanze, si possono ottenere da 16 a 24 kg di prodotto e il profitto può arrivare fino a 1,9 milioni di dollari.

Se invece il fentanyl viene smerciato tal quale, essendo molto potente, con soli 10 grammi si arriva a produrne più di 300 dosi, che hanno di solito un prezzo compreso tra i 10 e i 60 dollari, a seconda della zona di spaccio. Dato il prezzo abbordabile, anch’esso causa dell’aumento delle overdosi da fentanyl, questa sostanza è consuma-

ta soprattutto tra le fasce più deboli della popolazione americana, in primis gli afroamericani seguiti dai latinoamericani.

Sperimentazioni

Mentre negli Usa si tiene il conto delle morti da overdose, in Messico nessuno se ne cura, per cui i narcotrafficanti possono sperimentare liberamente le nuove combinazioni del fentanyl con altre droghe.

Il problema è quello di riuscire a rendere i clienti dipendenti, senza ucciderli con dosi letali, ma per questo occorre sperimentare su esseri umani.

Le cavie vengono reclutate solitamente nei quartieri marginali di alcune città, tra cui Tijuana, Mexicali e Ciudad Juárez con distribuzioni gratuite o a bassissimo prezzo.

A seguito di queste sperimentazioni, molti giovani sono morti e moltissimi sono diventati dipendenti. Si stima che nel 2018 solo a Tijuana e Mexicali vi fossero almeno mezzo milione di dipendenti da sostanze. I centri di disintossicazione presenti solo in queste due città sono 76.

Negli Stati Uniti si sono susseguite tre ondate di crescente consumo di oppiacei (morfina e sostanze similari) e di oppiodi (sostanze con attività morfino-simile), con conseguente aumento delle morti per overdose. Secondo i dati del Cdc (Center for disease control and prevention), agenzia federale del Dipartimento della salute statunitense, la prima ondata si è verificata come conseguenza dell’aumento delle prescrizioni di oppioidi negli anni Novanta, a cui ha fatto seguito un aumento dei decessi da overdose a partire dal 1999.

Si sospetta che, in qualche caso, possano avere fatto uso degli oppioidi anche i familiari dei pazienti, avendo spesso a disposizione le rimanenze del farmaco, per eccesso di prescrizione.

La seconda ondata ha avuto inizio nel 2010, quando è aumentato notevolmente il numero dei decessi per overdose da eroina, cercata da chi non necessitava più di controllare il dolore, ma era ormai diventato dipendente da oppiacei ed era quindi portato a cercarli nel mercato illegale.

La terza ondata è cominciata nel 2013 con un significativo aumento dei decessi da overdose dovuta agli oppioidi sintetici, soprattutto il fentanyl prodotto illegalmente e spesso mescolato ad altre sostanze.

Attualmente gli oppioidi sintetici sono la prima causa di morte sotto i cinquant’anni negli Usa, dove si registrano circa 200 morti al giorno. Nella sola New York ci sono stati tremila decessi per overdose nel 2023. Tuttavia il primato delle morti per overdose spetta a Filadelfia (dove sta emergendo anche il problema del fentanyl tagliato con xilazina, un potente sedativo, analgesico e miorilassante per uso animale, altrimenti conosciuta come tranq), seguita da San Francisco.

Tra il 2013 e il 2021 negli Usa è stato rilevato un aumento di 30 volte dei decessi correlati al fentanyl in età pediatrica e tra gli adolescenti. Mentre per questi ultimi è ipotizzabile il consumo di stupefacenti a scopo ricreativo, per i bambini non si può fare a meno di pensare alla carenza delle cure parentali e soprattutto di attenzione da parte dei familiari consumatori di oppioidi, che molto probabilmente lasciano le sostanze incustodite e a portata di mano dei piccoli.

Le droghe su misura

Come fanno i narcotrafficanti a eludere i controlli e a immettere sul mercato grandi quantitativi di sostanze stupefacenti? La risposta sta nelle designer drug o «droghe su misura», cioè molecole sintetizzate da chimici clandestini che cambiano qualche parte della molecola originale in modo che la nuova sostanza imiti l’effetto del model-

lo di partenza senza essere riconosciuta dai sistemi di controllo. La categoria di designer drug in più rapida espansione è proprio quella degli oppioidi sintetici. Basta pensare che nel 2009 l’Unodc (United nations office on drugs and crime) registrava un solo oppioide costruito «su misura», mentre nel 2023 erano già 132. Le designer drugs riescono a circolare liberamente e legalmente finché non vengono riconosciute, cosa che necessita di test sempre nuovi e più sofisticati. Gran parte delle droghe su misura attualmente in circolo appartengono a quattro categorie: i cannabinoidi sintetici, i catinoni, le fenetilammine e gli oppioidi sintetici. Ciascuna di queste categorie comprende centinaia di molecole molto diverse per natura chimica ed effetti. Queste sostanze sono prodotte principalmente in Cina e India, ma dal 2015 sono stati scoperti almeno 52 laboratori di sintesi clandestina anche in Europa.

Il ruolo del web

Il mercato di queste sostanze è spesso su internet, sia nel deep web che su normali siti dediti alla vendita di prodotti apparentemente «innocenti»: i cannabinoidi sintetici spruzzati su mix di piante secche da fumare sono venduti come incensi; i catinoni, che si presentano come polveri cristalline e si confondono facilmente con sali da bagno o fertilizzanti, e come tali vengono smerciati. Qualche volta vengono venduti come composti chimici per laboratori di ricerca.

Nei primi anni Novanta, grazie all’avvento di internet, non solo è stato creato un mercato di sostanze stupefacenti sul web, ma per molti chimici clandestini è stato possibile scambiarsi informazioni e, soprattutto, accedere liberamente alla letteratura scientifica, quindi alle procedure di sintesi. In pratica, le ricette sono sul web e i chimici-cuochi producono e vendono dai laboratori clandestini.

Ad esempio, uno studio risalente al 1974 della Janssen Pharmaceutica ha permesso ai chimici clandestini di sintetizzare i derivati del fentanyl, altrimenti detti fentenili. È chiaro quindi che molte designer drugs derivano da molecole di ricerca biomedica e potrebbero pertanto tornare utili nella pratica medica per il loro potenziale terapeutico. Per non parlare del possibile utilizzo in questo campo dell’Intelligenza artificiale (Ia).

Nel 2021 un gruppo di ricerca diretto da David Wishart dell’Università dell’Alberta in Canada ha messo a punto una Ia chiamata DarkNps (New psychoactive substances), la quale ha assimilato le strutture di 1.753 sostanze psicoattive note e ha generato circa 9 milioni di varianti con una capacità di prevedere circa il 90% delle nuove droghe prodotte dai chimici clandestini, rivelandosi utilissima nella lotta al narcotraffico. Tuttavia, le Ia di questo tipo potrebbero presto diventare delle ottime assistenti anche per i chimici clandestini. Nel contempo potrebbero ideare e realizzare la sintesi di nuove molecole utili a scopo terapeutico. Come sempre la scienza è neutra e sta a noi usarla bene o male.

Rosanna Novara Topino